|

|||||||||||

|

|

#61 | |

|

Premium

Datum registracije: May 2014

Lokacija: istra

Postovi: 3,526

|

Citiraj:

meni se full sviđaju ti novi kineski mini pc-jevi sa N100/150 procevima, cijela igračka troši 5-6W, iako ipak vrtim brand mini pc-jeve (hp i dell). lenovo imam samo sff. sve navedeno ima intel T procesore i struje troši koliko troši, nisu baš štedljivi kao N100. s druge strane, u ovo ludo inflatorno vrijeme gdje sve živo poskupljuje na tjednoj bazi, struja je i dalje cca 1kn/1kWh pa na kraju trošak homelaba ispadne zanemariv. uzmi neki mini pc ako ti baš trebaju male dimenzije, u protivno sff će ti biti komotniji, lakši upgrade kroz godine, ima više mjesta za diskove, veće i tiše ventilatore... ja sam u lenovo sff utrpao 2 x 3.5" diska i butabilni nvme. u mini pc ćeš bez većih modifikacija i kemija utrpat max 2 m2 diska i 1 x 2.5" diskić. em zbog dostupnih konekcija, em fizički zbog mjesta. |

|

|

|

|

|

|

#62 | ||

|

Premium

Datum registracije: Jun 2020

Lokacija: Zagreb

Postovi: 173

|

Citiraj:

Citiraj:

immich je za sada samo testno instaliran, nisam oduševljen što kod uploada razbaca i preimenuje slike ima li smisla zanemarit to i svejedno se prebaciti na immich? u smislu brzine, organizacije, korisničkog iskustva korištenja... stroj je hp mini g2 (dual core amd a6-8570e + 12GB ram) |

||

|

|

|

|

|

#63 | |

|

Premium

Datum registracije: Nov 2004

Lokacija: HR

Postovi: 991

|

nez gdje da podijelim ovo cudo. idealno sto mi treba. https://github.com/9001/copyparty Citiraj:

https://a.ocv.me/pub/demo/ Radi na svemu |

|

|

|

|

|

|

#64 | |

|

Premium

Datum registracije: Jul 2021

Lokacija: Sesvete

Postovi: 1,111

|

Citiraj:

__________________

tomek@vz: ajd nemoj | Mali Čile SAD Češka Peru | Windows Free |

|

|

|

|

|

|

#65 | ||

|

Premium

Datum registracije: Oct 2008

Lokacija: Dbk

Postovi: 1,315

|

Citiraj:

Proxmox daje najviše fleksibilnosti i super ga je poznavati, ali ako tu ide samo Immich i HomeAssistant ja bih napravio instalaciju Debiana bez GUIja, instalirao Docker u njega, Portainer i ta dva kontejnera i to je to. Uključiš mu automatic security updates i zaboraviš na njega. Backup složiš kao cron job za rsync. Umjesto Debiana može i neki drugi flavor, ali poželjno bez GUIja da nemaš nepotrebni overhead, sve se ionako upravlja preko web sučelja ili shella. Za potrošnju pogledam pa javim. Citiraj:

To je već pitanje kako kome odgovara, meni Immich radi dobro. Upload obično odradim preko immich-go programa, stavim mu u parametar da mi radi albume kao foldere i to je to. Code:

.\immich-go -server=http://192.168.x.y:2283 -key=api-key API key generiraš u Immich sučelju, a IP staviš koji jest. Taj immich-go radi na Windowsima i Linuxu. U ovom slučaju će uzeti folder images i uploadati ga u Immich kreirajući album za svaki podfolder iz toga images foldera. |

||

|

|

|

|

|

#66 |

|

Registered User

Datum registracije: Oct 2003

Lokacija: Zagreb, Trešnjevka

Postovi: 5,777

|

Evo moj setup:  U boravku je ruter (tp link er8411), fiber do 10g switcha u sobi gdje je taj 10" rack u kallaxu. U racku synology ds918+, 8x10g sfp+ switch, 8x1g poe switch, minisforum ms-a1 sa ryzenom 8700g. U kompu neka 10g sfp+ kartica sa alije. Jos mjesec dana pa mi uvode fiber, bit ce onda 10g cijelim putem. |

|

|

|

|

|

#67 |

|

49%winner

Datum registracije: Sep 2007

Lokacija: PU

Postovi: 10,178

|

Dugo godina već koristim Proxmox Backup Server povezan na NAS preko NFS-a, imao sam nekoliko situacija godišnje gdje PBS jednostavno izgubi vezu s NAS-om, pa onda ni Proxmox ne može odraditi backupove itd itd... U principu samo reset NFS postavki na strani NAS-a riješi problem (ili reboot NAS-a), ali nije to to i ostavlja šugav okus u ustima. Nije pitanje permissiona, nije pitanje reboota PVE ili PBS-a... čudno i nepredvidivo. Ako je još netko imao ovakav problem, možda mu ovaj tutorial pomogne da unaprijedi setup: https://www.derekseaman.com/2025/08/...datastore.html Derek je potpuno updejtao sve tutoriale vezano uz PVE+PBS+NAS/S3 pa možda nekome bude korisno: https://www.derekseaman.com/2025/08/...og-series.html Ja se nekako nadam da će PBS u kombinaciji s LUN-om biti dugoročno stabilnije rješenje, živi bili.

__________________

♕ Keep calm and fastboot oem unlock. ♕

|

|

|

|

|

|

#68 |

|

Premium

Datum registracije: Nov 2004

Lokacija: HR

Postovi: 991

|

ima netko preporuku za pcie sas kontroler koji bi bio plug nad pray u proxmox? soft raid. tnx |

|

|

|

|

|

#69 | |

|

Premium

Datum registracije: Oct 2008

Lokacija: Dbk

Postovi: 1,315

|

Citiraj:

Interesting, meni se takav setup vrti na 8 sajtova već godinu dana bez problema. PBS sam digao na Proxmox VE hostu kao LXC kontejner, ali sam morao staviti da je privileged da bi mogao koristiti direktno NFS share. Druga opcija gdje može biti unprivileged je da se NFS mapira u samom ProxmoxVE pa onda stavi kao mount point za PBS kontejner. NAS je Synology DS723+, spojen kroz switch sa ProxmoxVE hostom. |

|

|

|

|

|

|

#70 |

|

49%winner

Datum registracije: Sep 2007

Lokacija: PU

Postovi: 10,178

|

Sjecam se, negdje smo vec tipkali oko toga. Kod mene je PBS bio dignut kao VM na PVE hostu, ali u principu isti setup. Samo ove godine pamtim da mi se to dvaput dogodilo i ovaj zadnji put sam isao redom debugirati prije nego rebootam svu opremu. I ne znam zasto se to dogodilo. Rjesenje je bilo: na NAS-u sam otisao u settings - shared folders - [pbs shared folder] - edit - nfs permission - doslovno sam samo "resetirao" IP, prvo sam stavio neki random, sejvao, opet otvorio i stavio onaj prethodni IP od PBS-a, sejvao - sve magicno proradilo i PBS je momentalno reconnectao mount. Ovaj novi princip s iSCSI LUN-om mi je malo prekompliciran za razumjeti, puno nepoznanica, setup skripte koje bi trebalo odrzavati (autor) ili cuvati na sigurnom da ne bi nestale... Moram jos odraditi dissaster test, koliko je lako reconnectati se na LUN itd. Na kraju sam iz svega ovoga napravio i nesto korisno - vratio sam PBS VM na NAS just in case da se ne moram zezati s preslagivanjem, a na NAS sam vratio i proxy manager jer otkad sam poceo koristiti domenu za lokalne servise, sad mi smeta kad je PVE offline. NAS mi je jedini hw s uptimeom vecim od samog rutera.

__________________

♕ Keep calm and fastboot oem unlock. ♕

|

|

|

|

|

|

#71 |

|

49%winner

Datum registracije: Sep 2007

Lokacija: PU

Postovi: 10,178

|

Ok nije neka novost da proxmox voli "papati" lose nvme diskove. Kupio sam saku onih 2230 diskica za proxmox sistem+vm/lxc i slozio zfs raid1. Ono, ako jedan rikne, zamijenim ga i bok. Ono sto mogu primjetiti je da wear diskova ide oko 1%/tjedno. Nisam se ni okrenuo vec sam na 12%. To mi nema nekog smisla. Nedavno sam nabavio malo manju saku samsung pm981 diskova u nadi da na njih stavim samo instalaciju proxmoxa (i da ce biti malo otporniji). Ima li to smisla raditi s tim levelom nvme diskova? Ili da instalaciju jednostavno stavim na hdd (onda nemam opciju raida), a virtualke na nvme? Kakve vi diskove koristite i pozive li vise od nekoliko godine?

__________________

♕ Keep calm and fastboot oem unlock. ♕

|

|

|

|

|

|

#72 |

|

N0teb00k n00b

Datum registracije: Jan 2005

Lokacija: Zagreb/Koprivnica

Postovi: 2,111

|

TrueNAS sa 2x ZFS pool-a 3x 2TB Crucial MX500 - na poolu se vrte par VM ovaa (nextcloud, haproxy, pihole, pritunl) i *arr + plex apovi bonus da za homelab glume i iscsi storage i onda se gore vrti od 5-10 vm-ova raznih profila K meni su došli sa 80, 40 i 40% "lajfa" pred 3 godine (tada s preko 5+ godina starosti nakon rada u nekakav složenac storage-u za cluster). Sad su na 70, 29 i 34 ak je vjerovat smartu. Tak da reko bi ak imaš šrotex neki sa upitnim TBW, da ziher ga razdere, al iole OK ssd bi trebao skroz uredno živjeti. Nekakve samsunge sličnog imena imam u cluster nodovima, pa dok radim razne kemije oko backupa i testiram neke stvari ispišu 3-4 puta svoj kapacitet u vikendu bez problema - njih nisam ni pogledal, al se niti ne brinem s obzirom da MX500 kuca ko vurica.

__________________

|

|

|

|

|

|

#73 |

|

Uptime 99.99%

Datum registracije: Nov 2001

Lokacija: Zagreb

Postovi: 2,654

|

Nemojte stavljati ZFS, pa vam nece trositi diskove. To nije to proxmoxa nego do ZFS-a, stavite na losije diskoce LVM-thin i nece se diskovi tako trositi. ZFS bi najbolje bilo staviti na enterprise diskove, onda necete vjerojatno nikad potrositi ssd. Ja na nekima imam 800TB writa i 1.1PB reada i jos su na 100%. Napravio sam ZFS RAID 1 na consumer diskovima, samo su sistemski diskovi i svaki mjesec izgube 1-2%, a kad sam probao napraviti backup na njih usporili su se do 10MB/s, tako da ZFS jednostavno nije za takve diskove. Sent from my SM-S931B using Tapatalk

__________________

“Those who surrender freedom for security will not have, nor do they deserve, either one.” Zadnje izmijenjeno od: Bono. 12.11.2025. u 00:24. |

|

|

|

|

|

#74 |

|

N0teb00k n00b

Datum registracije: Jan 2005

Lokacija: Zagreb/Koprivnica

Postovi: 2,111

|

Cek cek, 8g stari 2tb diskovi sa jos dosta lajfa, a citav zivot rade debelo iznad "planiranog" je tebi brzo? Kolko bi consumer oprema trebala raditi? Sent from my 2201116SG using Tapatalk

__________________

|

|

|

|

|

|

#75 |

|

Moderator

Datum registracije: Sep 2006

Lokacija: St

Postovi: 23,567

|

Šta fali običnom ext4 ? |

|

|

|

|

|

#77 |

|

Premium

Datum registracije: Aug 2004

Lokacija: Zabok

Postovi: 3,411

|

|

|

|

|

|

|

#78 |

|

49%winner

Datum registracije: Sep 2007

Lokacija: PU

Postovi: 10,178

|

Koje su mi onda opcije za raid1 setup na kojem bi bili i os i vm storage? Zelim sve vrtiti na dva diska, nemam potrebe za icim drugim. Btrfs raid 1 mi je nesto manje poznat i out of the box ga ne mogu natjerati da se boota ako mu maknem jedan disk. Mnogi spominju dodavanje "rootflags=degraded" umjesto "quiet" u grub ali nece ni tad. LVM raid1 trazi dosta koraka i to mi je bas spansko selo. Instalacija koliko vidim ide na jedan disk pa se kasnije siri na drugi disk i podesi raid1. Ono, kao da citam erotiku na madjarskom. I sad sam u situaciji koju zecju rupu ispratiti do kraja. Znaci samo zelim imati os i vm storage u raid1, da sve radi ako disk prdne i da ga s par komandi mogu zamijeniti, ali da sustav moze raditi kad se to desi.

__________________

♕ Keep calm and fastboot oem unlock. ♕

|

|

|

|

|

|

#79 | |

|

White Rabbit

Datum registracije: May 2006

Lokacija: -

Postovi: 5,113

|

Citiraj:

mdadm software raid slozi. Na MD diskovima onda slozi normalni LVM+EXT4 konstrukt i bok. BTRFS izbjegavaj. P.S.: https://support.hpe.com/hpesc/public...ocLocale=en_US Zadnje izmijenjeno od: tomek@vz. 12.11.2025. u 15:42. |

|

|

|

|

|

|

#81 |

|

White Rabbit

Datum registracije: May 2006

Lokacija: -

Postovi: 5,113

|

|

|

|

|

|

|

#82 |

|

Premium

Datum registracije: Nov 2004

Lokacija: HR

Postovi: 991

|

|

|

|

|

|

|

#83 |

|

Does youer dewg byte?

Datum registracije: May 2006

Lokacija: Zagreb

Postovi: 1,948

|

Zaboravi na raid. Jedan SSD nek ti služi samo za OS i eventualno za ISO datoteke itd. Drugi koristi za virtualke. Kroz proxmenux skripte optimiziraj malo Proxmox da bude lakši za SSD. Bekupni tu i tam virtualke/kontenjere and bob's your uncle. Ak imaš samo dva mjesta za neki storage, ja apsolutno ne bih gurao pod mus neki raid kao rješenje.

__________________

" Have you tried turning it off and on again ? Are you sure it is plugged in ? "

|

|

|

|

|

|

#84 | |

|

49%winner

Datum registracije: Sep 2007

Lokacija: PU

Postovi: 10,178

|

ZFS pokusavam zamijeniti cim slicnijim rjesenjem Citiraj:

__________________

♕ Keep calm and fastboot oem unlock. ♕

|

|

|

|

|

|

|

#85 |

|

Does youer dewg byte?

Datum registracije: May 2006

Lokacija: Zagreb

Postovi: 1,948

|

I feel you. I opet, mislim da je ta cijela priča ZFS vs Ext4 wearout van proporcija. Da, ZFS je nešto teži na zapise, ali kad sagledaš da imaš nativni RAID/Volume/Filesystem manager u jednom, snapshotove na razini datotečnog sustava, taj famozni COW mehanizam, mogućnost stvaranja directory mode datasetova i zvolumea ( block devices ) opet kroz jedno sučelje... Postoje razne skripte za proxmox za općenitu optimizaciju wearouta, te bih o tome prvo razmišljao umjesto hoću li ići na mdraid/lvm-thin/ext4 rješenje ili ZFS. Nisam još vidio nijednu nekakvu direktnu usporedbu kroz 6 mjeseci sa istim usecaseom između ZFS i Ext4 da bi čovjek mogao reći, "da, ovaj filesystem je teži odokativno za xy% u odnosu na drugi". Wearout je tu, što je manji i jeftiniji nvme , to će proces ići brže.

__________________

" Have you tried turning it off and on again ? Are you sure it is plugged in ? "

|

|

|

|

|

|

#86 |

|

Premium

Datum registracije: Nov 2004

Lokacija: HR

Postovi: 991

|

puu.koliko vidim,preporuka je da se instalira čisti debian i onda digne proxmox https://forum.proxmox.com/threads/ho...-raid1.104079/ računaj da je sada debian 13 i proxmox ve 9 https://m.youtube.com/watch?v=hGgDi2...O1ajebQw%3D%3D |

|

|

|

|

|

#87 |

|

Uptime 99.99%

Datum registracije: Nov 2001

Lokacija: Zagreb

Postovi: 2,654

|

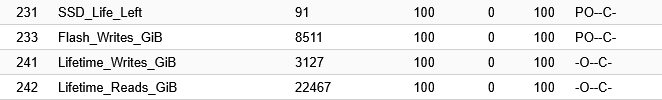

U dokumentaciji pise da ZFS nije za consumer opremu, ja sam stavio za test RAID 1 ZFS na jednoj masini i u 6mjeseci je ssd dosao sa 97% na 91% Imao sam zapisa nekih 400GB po SSD-u, a sad je na 3.1TB, za homelab ja bi rekao totalno nepotrebno, osim ako neces potrositi diskove. Ti diskovi su samo sistemski, ne vrti se ni jedan virtualac, a zapisuju ko ludi.  Produkcija je na Samsungu enterprise, a on ako se dobro sjecam moze do 20PB, tako da to nije problem. Critical Warning: 0x00 Temperature: 48 Celsius Available Spare: 100% Available Spare Threshold: 10% Percentage Used: 2% Data Units Read: 2,476,205,260 [1.26 PB] Data Units Written: 1,720,069,942 [880 TB] ZFS je odlican ako imas enterprise diskovi i hrpetinu rama, a ovako za po kuci mozda je EXT4 primjereniji.

__________________

“Those who surrender freedom for security will not have, nor do they deserve, either one.” |

|

|

|

|

|

#88 |

|

White Rabbit

Datum registracije: May 2006

Lokacija: -

Postovi: 5,113

|

Ajmo u rikverc sad sa svim. 1. Dali trebas redudantnost? Ak ne > zahebi RAID (ionak to nije backup) 2. Dokumentacija je uvijek dobrodosla cisto radi tebe samog, da znas sto i kako kad se skrsi. Bez obzira jel za po doma ili profesionalno. 3. Ovisno o tome kaj mislis ganjat sve - razmisli da proxmox puknes na neki manji SSD - tek tolko za OS - EXT4 i bok. Na mehanicki neki veliki disk (ili SSD zavisi kak si sa financijama) stavljas sve ostalo. Prednost takvog setupa je da sam radis Image OS diska "on the fly", bilo tar kompresijom bilo dd bilo necim trecem. Ak prdne disk - vratis image na novi disk i vozi dalje, 120-240GB diskovi idu za kikiriki a za OS dovoljno). Naravno i dalje radis vanjski backup svega sto ti je bitno, ako nista drugo rsnapshotom i bok. Naravno ima tu hrpa mogucnosti i varijacija na temu al po meni ovo ti je najjednostavnije jos da upogonis sto zelis a da te s vremenom glava ne zaboli kad nesto prdne. P.S.- ovo pod stavkom 3. mozes sve sa jednim diskom izvesti ako postavis LVM kak spada, stavio sam ovu soluciju kao primarnu cisto jer je sa aspekta pocetnika mozda jednostavnija. |

|

|

|

|

|

#89 |

|

Uptime 99.99%

Datum registracije: Nov 2001

Lokacija: Zagreb

Postovi: 2,654

|

Ovo je wear 120GB Kinstona, nije na tom serveru nista kriticno i wear me toliko ni ne smeta kao pad performansi kad sam backup radio. Bas me zanima kad ce crknuti, na koliko % healtha i na koliko zapisanih TB. Ako se dobro sjecam rated je na 40TBW.

__________________

“Those who surrender freedom for security will not have, nor do they deserve, either one.” |

|

|

|

|

|

#90 | |

|

White Rabbit

Datum registracije: May 2006

Lokacija: -

Postovi: 5,113

|

Citiraj:

Moguci workaround: tmpfs za sve ili vecinu toga sto je samo /tmp - na taj nacin sam preferirao olaksati SSD prije par godina jos  . Naravno nece pokriti sve ali olaksava malo situaciju sa cestim zapisivanjem na disk. . Naravno nece pokriti sve ali olaksava malo situaciju sa cestim zapisivanjem na disk. |

|

|

|

|

|

|

|